نحن مستعدون لمساعدتك

Hardw/AI: لماذا أصبحت 192 جيجابايت من VRAM «الحد الأدنى الصحي» الجديد لعمليات Inference

بحلول نهاية عام 2025، وصلت الصناعة إلى نقطة تحول: تجاوزت تكاليف التشغيل الرأسمالية (CAPEX) الخاصة بتشغيل النماذج (Inference) تكاليف التدريب لأول مرة. لكن نشر نماذج Dense 400B+ (مثل Llama 3.1 405B) في البيئات التجارية اصطدم بحدود فيزيائية قاسية: معيار العصر البالغ 80 جيجابايت من الذاكرة على H100 أصبح عنق زجاجة يقتل جدوى المشاريع اقتصادياً.

فيما يلي تحليل يوضح لماذا أصبحت الذاكرة أكثر أهمية من FLOPS، ونظرة واقعية على مواصفات B200 وMI325X بدون أي تزيين تسويقي.

تشريح «جدار الذاكرة»

في Inference لنماذج LLM، ننافس على مقياسين أساسيين: Time To First Token (TTFT) وInter-Token Latency (ITL).

القاعدة الذهبية: البيانات الساخنة (الأوزان + KV Cache) يجب أن تبقى داخل HBM.

إذا لم يتسع النموذج داخل VRAM وبدأ CPU Offloading، فالنتيجة كارثية:

- هاوية عرض النطاق: الانتقال من HBM3e (~8 TB/s) إلى DDR5 (~400–800 GB/s لكل مقبس). فرق بمقدار 10–20 مرة.

- انهيار التوليد: تنخفض السرعة من أكثر من 100 توكن/ثانية إلى 2–3 توكن/ثانية — وهو أمر غير مقبول لروبوتات الدردشة، والمساعدات الذكية، أو خطوط RAG في الزمن الحقيقي.

KV Cache: المستهلك الخفي للذاكرة

الكثيرون ينسون أن حجم أوزان النموذج (مثلاً ~810 جيجابايت لـ 405B بدقة FP16) هو نصف المشكلة فقط. النصف الآخر هو Context Window.

عند 128k توكن من السياق وبـ Batch Size يساوي 64، قد يستهلك KV cache مئات الجيجابايت.

- الواقع: حتى مع استخدام FP8 quantization بشكل مكثف، تدفع السياقات الطويلة KV cache إلى إزاحة أوزان النموذج.

- النتيجة: لا يكفي «أن يتسع النموذج» فقط — بل تحتاج إلى هامش ذاكرة إضافي بنسبة 30–40٪ للتخزين المؤقت الديناميكي لكل جلسة.

معركة المواصفات: B200 مقابل MI325X (تحقق من الحقائق)

استجاب السوق بشرائح توفر كثافة ذاكرة أعلى. لكن من الضروري التمييز بين أوراق المواصفات الحقيقية وشرائح التسويق.

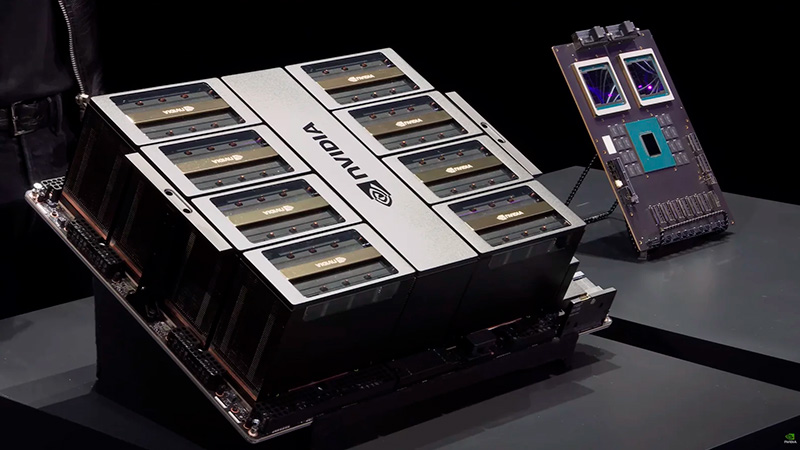

1. Nvidia B200 (Blackwell)

التسويق يدّعي 192 جيجابايت من HBM3e.

الواقع الهندسي: الشريحة تحتوي فعلياً على 192 جيجابايت (8 شرائح × 24 جيجابايت). لكن في الأنظمة الإنتاجية (HGX/DGX) يحصل المستخدم عادةً على 180 جيجابايت — بينما تُحجز الـ 12 جيجابايت المتبقية لـ ECC وتحسين العائد.

- الخلاصة: ترقية كبيرة مقارنة بـ 80 جيجابايت في H100، لكن لنماذج 400B+ على عقدة واحدة (8× GPU)، تظل استراتيجية sharding حاسمة.

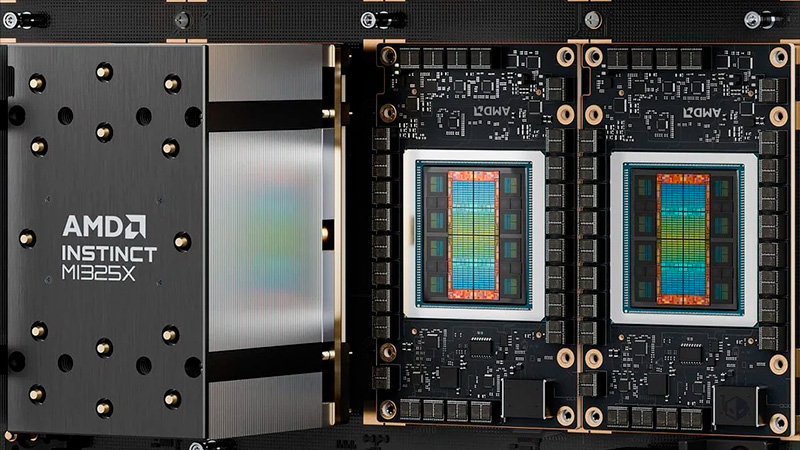

2. AMD Instinct MI325X

هناك رقم غير صحيح — 288 جيجابايت — يتم تداوله على الإنترنت.

الواقع الهندسي: MI325X (الرائد في أواخر 2025) يأتي بذاكرة 256 جيجابايت من HBM3e. رقم 288 جيجابايت يعود إلى الجيل القادم (CDNA 4)، وهو غير متوفر تجارياً بعد.

- الخلاصة: حتى مع 256 جيجابايت، تتفوق AMD في الذاكرة لكل GPU. وهذا يسمح بـ: — استضافة Llama 3.1 70B على GPU واحد مع هامش سياق كبير — واستضافة 405B على 4 وحدات GPU بدلاً من 8.

| الخاصية | Nvidia B200 | AMD Instinct MI325X |

|---|---|---|

| الذاكرة (القابلة للاستخدام) | ~180 GB HBM3e | 256 GB HBM3e |

| عرض النطاق | ~8 TB/s | ~6 TB/s |

| الاستخدام النموذجي | أقصى أداء (FP4/FP8)، منظومة CUDA مغلقة. | أقصى سعة (RAG، سياقات طويلة)، منظومة ROCm مفتوحة. |

اتجاهات 2026: المعركة مع Inter-GPU Link

لماذا نقاتل بهذه الشراسة من أجل الذاكرة لكل شريحة؟

لتشغيل نموذج بمستوى GPT-4/5، نستخدم Tensor Parallelism، حيث يتم تقسيم طبقات النموذج عبر 8 أو 16 وحدة GPU.

المشكلة: حتى NVLink Gen-5 يضيف زمناً انتقالياً. عدد أقل من وحدات GPU → Inference أسرع → TCO أقل. في عام 2026، الفائز لن يكون من يمتلك FLOPS أكثر، بل من يستطيع تشغيل نموذج «ضخم» على أقل عدد من الشرائح.

خلاصة HYPERPC

في HYPERPC، نرى الشركات تنتقل من «التدريب بأي ثمن» إلى Inference فعّال. سباق عدد المعاملات تحوّل إلى سباق على VRAM.

لعملائنا من فئة المؤسسات الذين ينشرون LLMs داخل مراكزهم (on-prem)، نوصي بالاستراتيجية التالية:

- لا توفّر في VRAM: إذا كانت مهمتك تعتمد على RAG مع مستندات ضخمة، اختر وحدات GPU بأقصى سعة ذاكرة. نقص الذاكرة لا يمكن تعويضه بواسطة CPU.

- وازن المنظومة: تظل Nvidia B200 معياراً لخطوط CUDA المعقدة، لكن وحدات AMD بسعة 256 جيجابايت جذابة جداً لأحمال السياقات الطويلة.

- استخدم منصات جاهزة: بناء مثل هذه العناقيد يدوياً قد يؤدي إلى مشاكل في التبريد والطاقة. تم تصميم خوادم HYPERPC AI & HPC لتحمّل أحمال حرارية تتجاوز 700 واط، مع ضمان تشغيل مستقر على مدار الساعة دون اختناق الأداء.

استثمر في الذاكرة اليوم لتتجنب الدفع مقابل خوادم خاملة غداً.

المصادر والوثائق التقنية

يعتمد هذا المقال على بيانات من المواصفات الرسمية ومدونات هندسية:

- Nvidia Blackwell Architecture Technical Brief Nvidia Technical Blog / Datasheets — تفاصيل حول بنية B200، مواصفات الذاكرة، وNVLink.

- AMD Instinct MI325X Specifications AMD Official Website - Instinct Accelerators — تأكيد سعة 256 جيجابايت من HBM3e.

- Meta Llama 3.1 Hardware Requirements Meta AI Engineering Blog — متطلبات الذاكرة لنماذج 405B (FP16/FP8).